Kolejnym zabiegiem który służy poprawieniu wyszukiwalności i dostępności sklepu internetowego to wygenerowanie pliku robots.txt. Plik ten służy wskazaniu wyszukiwarce co ma, a co nie ma indeksować. Służy również wskazaniu pliku sitemaps.xml – mapy strony – ale o tym napiszemy innym razem. Wracając do tematu, sprecyzujmy do czego taki plik robots.txt się przydaje. Jeśli zawieramy pliki (zdjęcia, filmy, muzykę) z treściami których robot nie powinien zaindeksować do wyszukiwarki Google to możemy to wskazać za pomocą odpowiedniego polecenia aby omijał te miejsca. Niestety należy pamiętać, że jest to tylko wskazanie. Co prawda wyszukiwarka Google przestrzega tego, ale inne mogą ignorować istnienie pliku robots.txt i indeksować wszystko, co spotkają na swojej drodze ich roboty (crawlers).

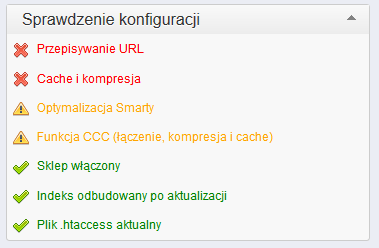

Przejdźmy do praktyki i wygenerujmy plik robots.txt w sklepie internetowym Prestashop 1.5. W panelu administracyjnym na pierwszej stronie po zalogowaniu widzimy okno jak poniżej:

Klikamy na pierwszą pozycję. W nowym oknie przechodzimy na sam dół strony

i klikamy przycisk: Generuj plik robots.txt. Plik powinien znaleźć się w katalogu głównym sklepu Prestashop, np. http://www.twojastrona.pl/robots.txt. Możemy go zobaczyć przy użyciu programu FTP.

Treść pliku została wygenerowana automatycznie i wygląda jak poniżej:

| # robots.txt automaticaly generated by PrestaShop e-commerce open-source solution # http://www.prestashop.com – http://www.prestashop.com/forums # This file is to prevent the crawling and indexing of certain parts # of your site by web crawlers and spiders run by sites like Yahoo! # and Google. By telling these „robots” where not to go on your site, # you save bandwidth and server resources. # For more information about the robots.txt standard, see: # http://www.robotstxt.org/wc/robots.html User-agent: * # Private pages Disallow: /*orderby= Disallow: /*orderway= Disallow: /*tag= Disallow: /*id_currency= Disallow: /*search_query= Disallow: /*back= Disallow: /*utm_source= Disallow: /*utm_medium= Disallow: /*utm_campaign= Disallow: /*n= Disallow: /*controller=addresses Disallow: /*controller=address Disallow: /*controller=authentication Disallow: /*controller=cart Disallow: /*controller=discount Disallow: /*controller=footer Disallow: /*controller=get-file Disallow: /*controller=header Disallow: /*controller=history Disallow: /*controller=identity Disallow: /*controller=images.inc Disallow: /*controller=init Disallow: /*controller=my-account Disallow: /*controller=order Disallow: /*controller=order-opc Disallow: /*controller=order-slip Disallow: /*controller=order-detail Disallow: /*controller=order-follow Disallow: /*controller=order-return Disallow: /*controller=order-confirmation Disallow: /*controller=pagination Disallow: /*controller=password Disallow: /*controller=pdf-invoice Disallow: /*controller=pdf-order-return Disallow: /*controller=pdf-order-slip Disallow: /*controller=product-sort Disallow: /*controller=search Disallow: /*controller=statistics Disallow: /*controller=attachment Disallow: /*controller=guest-tracking # Directories Disallow: /*classes/ Disallow: /*config/ Disallow: /*download/ Disallow: /*mails/ Disallow: /*modules/ Disallow: /*translations/ Disallow: /*tools/ # Files Disallow: /*pl/password-recovery Disallow: /*pl/address Disallow: /*pl/addresses Disallow: /*pl/authentication Disallow: /*pl/cart Disallow: /*pl/discount Disallow: /*pl/order-history Disallow: /*pl/identity Disallow: /*pl/my-account Disallow: /*pl/order-follow Disallow: /*pl/order-slip Disallow: /*pl/order Disallow: /*pl/search Disallow: /*pl/quick-order Disallow: /*pl/guest-tracking |

Polecenie User-agent: * wskazuje, że poniższe zakazy czyli Disallow będą dotyczyły wszystkich przeglądarek. Prestashop wygenerował pliki które nie powinny być przeglądane przez wyszukiwarki podczas budowania ich indeksu.

Jeśli posiadamy własne plik np zdjecie.jpg który nie powinien być indeksowany to możemy na końcu powyższego pliku dopisać takie polecenie:

Disallow: /zdjecie.jpg

Dla katalogu który ma być omijany przez robota wyszukiwarki napiszemy tak:

Disallow: /katalog/

Jak widać wygenerowanie pliku a nawet samodzielnie jego modyfikowanie nie jest takie trudne, jednak każdą ze zmian należy dokonywać z ostrożnością, aby nie zabronić przez przypadek dostępu do stron z produktami w naszym sklepie. Jeszcze raz przypominamy, plik robots.txt nie służy ukryciu treści aby nikt do niej nie dotarł – to nie jest to samo co kodowanie. Plik ten natomiast służy tylko i wyłącznie wskazaniu co zaindeksować do wyszukiwarki która taki plik respektuje np. google.pl. Jeśli mamy plik z hasłami, czy innymi tajnymi danymi to powyższa metoda nie ukryje takich danych! Jeśli nie mamy potrzeby zmian w pliku robots.txt, pozostawmy go tak jak jest, samo wygenerowanie powodujące automatyczne wypełnienie poleceniami jak widać powyżej sprawdza się bardzo dobrze.